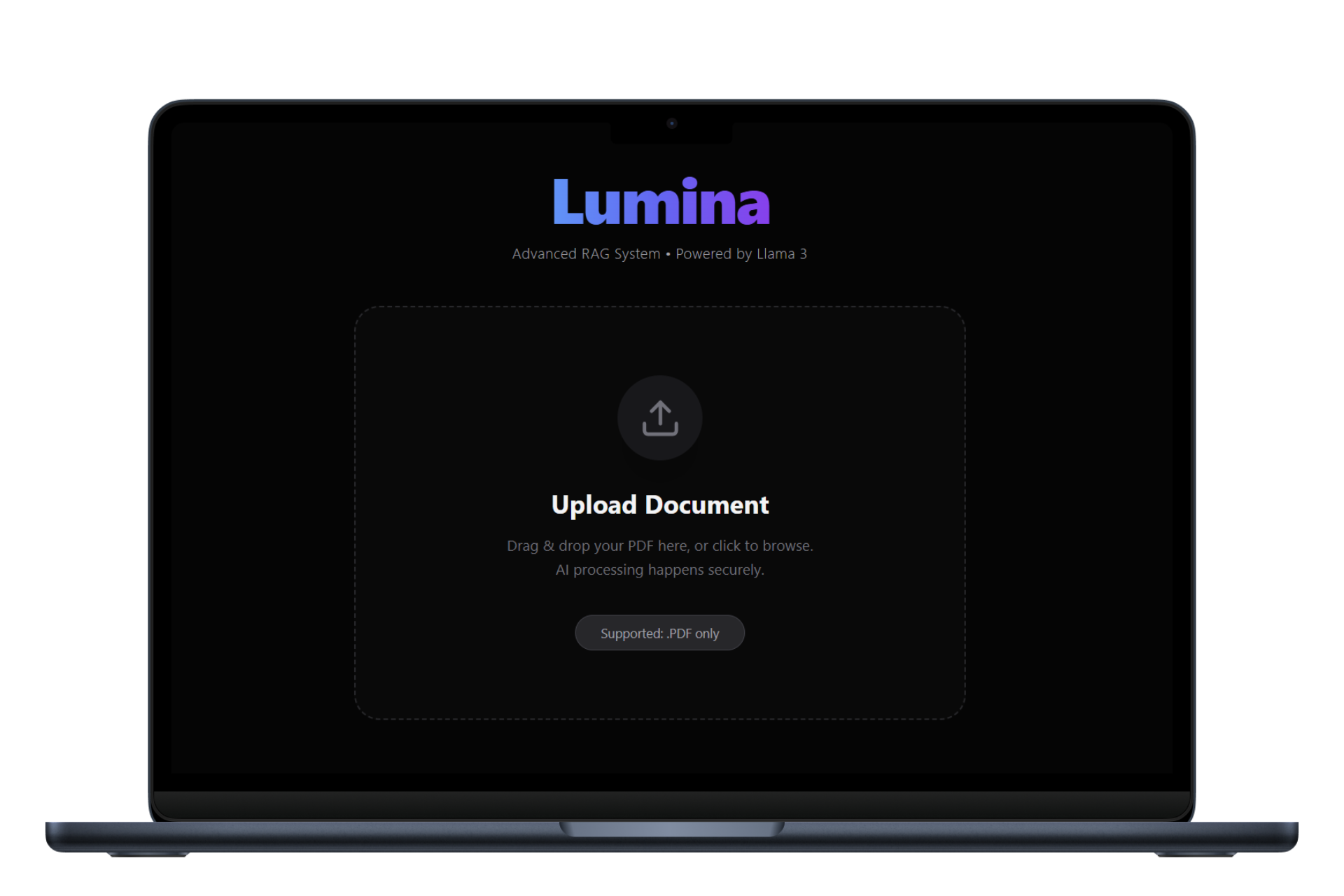

Lumina AI System

نظام ذكي لمعالجة الوثائق (RAG) يجمع بين خصوصية البيانات والأداء السحابي العالي.

تصفح الكود المصدري (GitHub)

التحديات الهندسية والحلول

عند بناء نظام "محادثة مع المستندات"، التحدي الأكبر ليس في استخدام الذكاء الاصطناعي فحسب، بل في دقة الاسترجاع (Retrieval Accuracy) والحفاظ على خصوصية البيانات. إليك كيف قمت بهندسة الحل من الصفر:

1. معالجة البيانات (Ingestion Pipeline)

بدلاً من إرسال الملفات للسحابة، قمت ببناء Pipeline محلي باستخدام LangChain. النظام يقوم بتقسيم ملفات PDF إلى "أجزاء دلالية" (Semantic Chunks) مع تداخل (Overlap) ذكي، مما يضمن أن السياق لا يضيع بين الفقرات، وهو أمر حيوي لدقة الإجابة لاحقاً.

2. التخزين المتجهي (Vector Store)

لضمان السرعة والخصوصية، استخدمت ChromaDB محلياً. يتم تحويل النصوص إلى متجهات رياضية (Embeddings) باستخدام نماذج HuggingFace الخفيفة. هذا يسمح بالبحث عن "المعنى" وليس "الكلمات المفتاحية" فقط، وبسرعة استجابة تقاس بالمللي ثانية.

3. الاستدلال الهجين (Hybrid Inference)

صممت نمط "استراتيجية" (Strategy Pattern) يمنح النظام مرونة عالية. يمكنه العمل بوضع Local (Ollama) للبيانات الحساسة جداً بدون إنترنت، أو التبديل لوضع Cloud (Groq) عندما نحتاج لقوة معالجة هائلة وسرعة خيالية.

كيف يعمل النظام (System Architecture)

1. Upload & Parsing

يتم رفع الملف واستخراج النصوص الخام وتنظيفها من الشوائب.

2. Embedding Generation

يتم تحويل النصوص إلى أرقام (Vectors) باستخدام نموذج `all-MiniLM-L6-v2`.

3. Semantic Search

عندما يسأل المستخدم، يبحث النظام عن أقرب الفقرات صلة بالسؤال (Cosine Similarity).

4. LLM Generation

يتم إرسال السؤال + الفقرات المستخرجة (فقط) إلى الـ LLM لتوليد إجابة دقيقة وموثقة.